Продовження (початок в статті Історія відеокарт — Частина 1)

Еволюційний відбір

Те, що на ринку з’являлися все більш нові та досконалі 3D-ігри та відеоплати, послужило приводом створення більш досконалих і найшвидших відеокарт. Віхою історії відеокарт був 1998 рік, який став роком народження адаптера Voodoo2, володів 8 або 12 Мб пам’яті EDO DRAM на борту і працював на частоті 100 МГц.

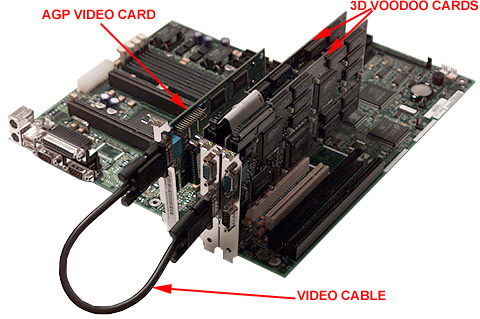

Voodoo2 з першим у світі SLI

Архітектура Voodoo2 була практично така ж, як і в Voodoo за винятком декількох особливостей. Першою особливістю був додатковий текстурний блок, за допомогою якої за 1 прохід візуалізації можна було накладати до двох текстур за прохід, що значно збільшило продуктивність. Друга особливість – картинка, що виводиться адаптером. Дозвіл картинки досягало 1024*768 пікселів при 12 Мб пам’яті і 800*600 у випадку з 8 Мб пам’яті при режимі кольору 16 біт. Але головне інновацією був режим SLI, який дозволяв спільно працювати відразу двом Voodoo2. Ця система була дуже і дуже дорогою, однак аналогів у фірм-конкурентів не було і в помині, а продуктивність була неймовірною.

Потужна конструкція: дві Voodoo2 в режимі SLI

В цьому році NVIDIA не змогла наздогнати 3Dfx, але з’явилася в тому році Riva TNT (NV4) стала поштовхом до успіху компанії. За 2 роки фахівці NVIDIA створили нову архітектуру, яка дала RIVA TNT 2 конвеєра для рендеринга, тобто вона так само, як і Voodoo2 накладала 2 текстури за прохід. RIVA TNT працювала на частоті 90 МГц, а пам’ять у неї була SDRAM, обсяг якої був 16 Мб.

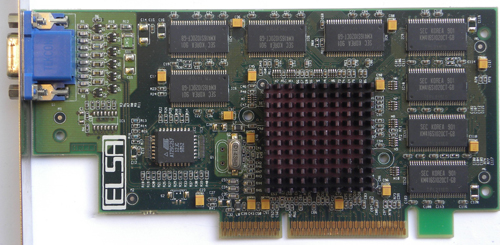

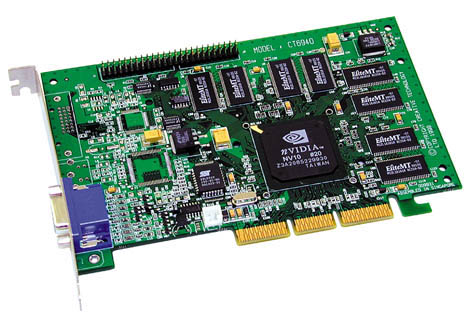

RIVA TNT від NVIDIA

Глибина кольору продукту NVIDIA була 32 біта, проте продуктивність при цьому режимі зменшувалася аж 2 рази, що було негативно зустрінута покупцями. Незважаючи на це RIVA TNT поклала початок рендерингу в 32-бітному кольорі, і незабаром з’явилися моделі, які давали прийнятну продуктивність в цьому режимі. Ще у RIVA TNT була можливість роботи з текстурами 1024*1024 пікселів, а для Voodoo2 максимумом були текстури розміром 256*256 точок.

Розвиток у ті роки бібліотеки від 3Dfx Glide було серйозною проблемою для NVIDIA, допомогу у вирішенні якої надавала, сама того не знаючи, Microsoft, активно поширювала Direct3D.

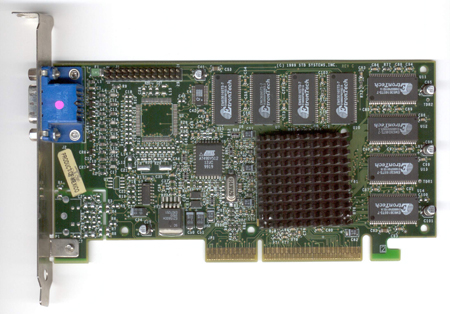

Компанія ATI намагалася не відставати від своїх конкурентів і випустила в 1998 році свою 3D Rage Pro, яка не мала особливого успіху та переваги перед конкурентами. Єдине, чим могла похвалитися ця відеокарта, так це продуктивність при обробці потоку стисненого DVD. Продуктивність в 3D у цього продукту була не краще відеокарт попереднього покоління, а підтримка OpenGL була всього лише «для галочки». З цих причин 3D Rage Pro майже ніяк не була оцінена споживачами і стала всього лише хорошим 2D-адаптером.

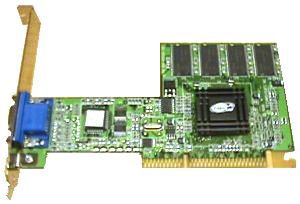

До речі про 2D. У ті роки було безліч виробників 2D-адаптерів, лідером серед яких була фірма Matrox, яка представила в 1998 році свій адаптер, призначений як для 2D, так і 3D. Цей чіп повністю підтримував 3D-рендерінг і міг тримати конкуренцію з Riva TNT від NVIDIA в плані продуктивності.

G200 володів чудовою продуктивністю в 2D, і, крім цього, забезпечував високу якість рендерингу у 3D з 16 і 32 біт кольору. Робочою частотою для G200 були від 84 до 90 МГц, він оснащувався двома шинами даних в 64 біта кожна. Забезпечуючи таку ж пропускну здатність, дане рішення давало менше латентності порівняно із звичайною 128-бітною шиною. До того ж, завдяки технології DIME, адаптер міг зберігати текстури з роздільною здатністю до 2048*2048 пікселів в системній пам’яті, а це рішення дало можливість зупинитися на об’єм відеопам’яті в 8 Мб, що допомогло продукту стати дешевше.

3D Rage Pro з роз’ємом для додатково підключається пам’яті

Повернутися до змісту

Зміна лідерів

На заході 90-х лідерами виробництва відеокарт були 3Dfx, що займала міцне перше місце, за ним слідувала NVIDIA, ну а далі їх намагалася наздогнати натовп інших виробників (серед яких виділялися ATI, Matrox і S3), які на той час були статистами. Визначальним став 1999 рік.

На початку року були анонсовані Voodoo3, G400, Rage 128 і Riva TNT2. Робоча частота у дітища 3Dfx була 183 МГц і цей адаптер підтримував SLI. Проте технологічні новинки обійшли стороною адаптер від 3Dfx, у якого були можливості 2D-адаптерів, однак у нього був всього один конвеєр для рендеринга і він не підтримував 32 біта кольору і текстури великого дозвіл.

Від 3Dfx Voodoo 3

Відповіддю від NVIDIA став чіп NV5, який встановлювався в TNT2. Головним для NVIDIA була відповідність технологічної новизни. Таким чином Riva TNT2 першою отримала підтримку AGP 4x, забезпечувала непогану продуктивність візуалізації 32 бітах кольору, а вона працювала на частоті 150 МГц і 183 МГц для пам’яті. На той час TNT2 була повністю конкурентоспроможним суперником для Voodoo3. Таким чином, беззастережне лідерство 3Dfx на даному етапі історії відеокарт виявилося під сумнівом.

Не відставати від гігантів змогла і Matrox, що випустила G400. Технології компанії, які були впроваджені в чіп G200, отримали розвиток. У G200 були дві шини в 128 біт кожна, частотою в 125-150 МГц і шину пам’яті 128 біт з частотою 166-200 МГц. Новинкою стала технологія EMBM (Environment mapped Bump mapping), яка стала апаратною підтримкою ефектів рельєфності текстур. Завдяки їй графіка вийшла на принципово новий рівень.

Matrox Millennium G400MAX і її два роз’єми для підключення моніторів

Подання технології EMBM

До всього іншого у G400 вперше з’явилася підтримка двох моніторів. Таким чином G400 змогла на час вийти на перше місце серед відеокарт. На жаль, G400 втрачала продуктивність в роботі з OpenGL іграми, а більшість ігор того часу не підтримували Direct3D.

ATI, все ще отстававшая від лідерів, випустила досить цікавий для геймерів Rage 128. Він був набагато дешевше новинок від NVIDIA і 3Dfx, однак швидкість рендеринга при 32 бітах кольору була вище RivaTNT, а також чіп отримав підтримку OpenGL і Direct3D. Таким чином справи у ATI пішли набагато краще.

Невеликий ривок від ATI: їх Rage 128

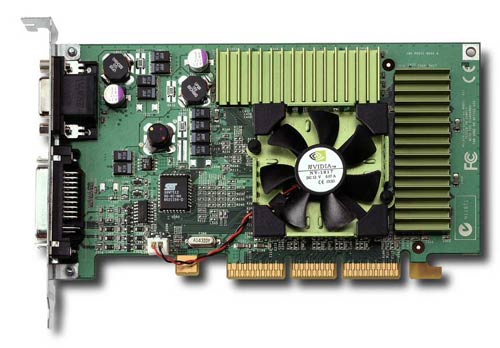

До кінця 1999 року настав ще один етап протистояння лідерів виробництва відеокарт. 3Dfx запустив VSA-100, який повинен був виправити відставання у технологічному плані, NVIDIA готувала NV10, що обіцяв стати «сюрпризом», а ATI і S3 намагалися прорватися на передові позиції своїми Rage Fury MAXX і Savage 2000 відповідно. Що ж пропонували користувачам ці компанії?

VSA-100 володіла технологією T-Buffer, яка забезпечувала постобробку зображення використовує кінематографічні спецефекти. Повноекранне згладжування (Full scene Anti-aliasing), розмиття в русі (Motion Blur), глибина різкості (Depth Of Field) і м’які тіні (Soft Shadows) повинні були поліпшити якість картинки без падіння продуктивності.

Перевагою NVIDIA стала технологія розрахунку трансформації та освітлення (Transform and Lighting, T&L). З використанням цієї технології з центрального процесора знімалася частина задач по розрахунку вершин трикутників, забезпечуючи тим самим приріст продуктивності в іграх.

ATI Rage Fury MAXX був по суті своїй з’єднанням двох Rage 128 Pro на одній платі, які формували кадри по черзі. Вартість повинна була стати величезною.

Надто дорога ATI Rage Fury MAXX

S3 Savage 2000 володів T&L, як і продукт NVIDIA, у нього була передова технологія стиску текстур. Цей адаптер планувався як дешева, більш технологічна альтернатива Voodoo3, здатна витіснити NVIDIA на другий план.

На ділі ж все виявилося зовсім не так. 3Dfx не встигла випустити свої Voodoo4, Voodoo5 і Voodoo6 до літа 2000 року. А ось NVIDIA змогла до того часу вивести у світ свій NV15, який був набагато потужнішим Voodoo6. Voodoo 4 і Voodoo5, що володіли одним чіпом серйозно програвали конкурентам в плані продуктивності, а двох – і четырехчиповые Voodoo5 були дорогими і неабияк грілися. Це стало ударом для 3Dfx, яка не так давно була флагманом виробництва відеокарт. Втрату лідируючої позиції відразу помітили кредитори.

Галасливий і зовсім не швидкий Voodoo5 з 4 чіпами

Вихід Savage 2000 від S3 відбувся трохи пізніше. T&L і стиснення текстур насправді добре працювали і давали збільшення продуктивності, але лише за підтримки цих технологій додатками. Таким чином при відсутності даної підтримки Savage 2000 серйозно програвав конкурентам, а S3 зовсім не цікавив творців ігор. Крім іншого, у цього продукту були великі проблеми з установкою драйверів, а також з порівняно низькою продуктивністю блоку T&L. Незважаючи на це, технологія S3TC, яка займалася стисненням текстур, зацікавила компанію Microsoft, і вони викупили її та ліцензували під назвою DXTC. Відповідно, відеокарти всіх компаній змогли отримати цю технологію.

Адаптер ATI в цілому став вдалим рішенням, але не для своєї ціни. До того ж для нього було дуже складно написати драйвер, який програмісти ATI змогли випустити лише через кілька місяців після того, як з’явився сам адаптер.

Краще за всіх став адаптер NVIDIA. GeForce 256 зміг випередити всі інші адаптери за рахунок відмінною функціональності. У нього було чотири конвеєра рендеринга, робоча частота 120 МГц і 32 Мб пам’яті (з частотою 166 МГц і 128-бітної шиною) SDRAM (яка з 2000 року стала DDR SDRAM). Не забули в NVIDIDA і про T&L, який починали підтримувати всі виходять гри.

Чудова GeForce 256

На жаль, свій штрих в цей етап історії відеокарт не змогла вписати Matrox. Вони не пішли принципом випуску нових адаптерів кожні 6 місяців, а G400 програвав GeForce через поганий продуктивності OpenGL, а також горезвісного T&L. Так, G400 став затребуваним лише тими, кому потрібно було використовувати для роботи або гри 2 монітора. У Matrox просто-напросто скінчилися ідеї.

Повернутися до змісту

Пара слів про TRUFORM

Відмінність карт бюджетного класу і карт топ-класу вкрай сильно помітно. Один з найголовніших показників цього – сума трикутників в кадрі. Чим вона вища, тим потужніше відеокарта знадобиться. А що стосується творців ігор? Навіщо створювати багато різно деталізованих моделей залежно від рівня відеокарти? З відповіддю допомогли в ATI створенням TruForm.

Той чіп, який підтримує цю технологію, може змінювати як полігональні об’єкти в лінійні, так і назад. У підсумку, моделі отримують плавність вище задуманої.

Єдиним мінусом є те, що технології просто необхідно присутність маркерів, які вказують на те, чим, де і як можна ускладнити модель і зробити її плавніше. А ось без цих маркерів будуть артефакти, такі як куби, які стали кулями і т. д. А без підтримки творців продукту з 3D-графікою від цих артефактів ніяк не позбутися…

Повернутися до змісту

Боротьба передовиків

Все йшло до того, що NVIDIA одноосібно очолить ринок. Вона купила банкрутів 3Dfx з її працівниками та розробками, створений чіп NVIDIA NV15 став хорошою модернізацією чіпів NV10, а дешеві версії її чіпів зайняли весь ринок, витіснивши конкурентів.

Але ATI довела NVIDIA свою повну конкурентоспроможність. У червні 2000 року вони випустили ATI Radeon, у якого було 64 Мб DDR SDRAM з шиною 128 біт, і він працював на частоті 183 МГц. Як і у адаптера NVIDIA, у Radeon був блок T&L, тим самим ATI показала і довела споживачам те, що в компаній немає ніякого технологічного розриву. До того ж їх продукт виявився дешевше.

Однак, Matrox поки не впадали у відчай. Вони випустили G450, який був більш досконалою версією G400 і був створений з використанням нових технологічних норм (180 проти 250 нм в порівнянні з G400), а пам’ять була більш швидка, однак на 64-розрядній шині, що не змінювало швидкість обміну з пам’яттю. В теорії, що у G400 був використаний новий техпроцес, повинно було збільшити тактову частоту чіпа, чого не сталося. У підсумку G450 розчарував геймерів, і Matrox наздогнати ATI і NVIDIA не змогла.

Повернутися до змісту

Безпідставна багатослівність BitBoys

В історії відеокарт варто відзначити фінську компанію BitBoys Oy. З’явившись раптово під кінець 90-х, компанія вражала пресу своїми анонсами, представляючи захмарні цифри продуктивності своїх чіпів. BitBoys була на рівні конкурентів, при набагато більшій продуктивності. Однак дуже складне питання: чи була можливість появи адаптерів «фінських казкарів», чи все ж це було фікцією? Давайте поміркуємо.

Команда обдарованих програмістів, всім відома як Future Crew, в 1991 році перейшла від створінь демо (програм-демонстрацій можливостей 3D-графіки) до створення чіпів. До цього часу вони вже перейменувалися в BitBoys. Знаючи, що таке 3D-графіка і «з чим її їдять», BitBoys задовго до появи 3Dfx зрозуміла всі можливості перспективи 3D-адаптерів і вирішили запропонувати ідеї TriTech.

TriTech недовго думаючи підписала контракт на розробку чіпа, який володів функціями 3D-прискорювача. Вихід цієї відеокарти, названої TriTech Pyramid3D, планувався на 1996 рік, а функції її обіцяли бути запаморочливими. У нього планувалася підтримка 2 накладання текстур за прохід, об’ємних текстур (EMBM), програмованого піксельного конвеєра, текстури до 1024*1024 пікселів і рендеринг у режимі 1600*1200 пікселів при 24-бітному кольорі. Вийшов цей чіп тільки в 1997 році, коли TriTech вже була розорена позовами за порушення патентних прав при випуску аудиоадаптеров. Таким чином Pyramyd3D так і не вийшов, а замість нього вийшло лише кілька прототипів.

Але банкрутство не сильно зачепило BitBoys, тому що Pyramyd3D працював у компанії було що показати потенційним замовникам, а технологія об’ємних текстур була ліцензована Matrox. Але фіни вирішили зробити свій новий чіп без сторонньої допомоги. Після цього почали з’являтися все нові і нові прес-релізи, щоразу все більш вражаючі.

BitBoys анонсували в 1999 році Glaze3D, який перевершував конкурентів в рази по можливостям. Головним досягненням фінської компанії виявилася швидка пам’ять в 9 Мб, яка була потрібна для зберігання з’являється на екрані картинки після візуалізації. Ну а текстури повинні були знаходитися в SDRAM, яка розміщувалася на самій платі. Також було обіцяно Thor, в якому повинні були реалізовані функції T&L і SLI.

Але минав час, але Glaze3D так і з’являвся. А ось конкуренти виробляли на світло чіпи все краще і краще, правда без особливих проривів, але все ж реально існуючі. Але Glaze3D вдосконалився! Правда так і не сходячи з паперу…Черговий анонс обіцяв, що з використанням Glaze3D Quake 3 зможе видавати аж 200 FPS при найкращій якості зображення. Ті модернізації, які були у нових чіпів-конкурентів, негайно з’являлися в анонсах Glaze3D, що, природно, породжувало все більшу і більшу недовіру.

Пройшов рік і BitBoys, одумавшись, перестали анонсувати Glaze3D і оголосили про прийдешнє появі чіпа під назвою Axe, призначеного для Avalanche3D. Характеристики чіпа були краще Glaze3D. Об’єм пам’яті став 12 Мб, ширина шини – 1024 розряду, чіп став підтримувати вершинні шейдери, а також була можливість використання двох чіпів разом.

BitBoys Axe. Як кажуть, а чи був хлопчик?

Однак Axe пішов слідом за Glaze3D – його так само «поховали». І тут же BitBoys анонсували чіп Hammer. До можливостей цього чіпа ставилася навіть підтримка накладення до 4 текстур за прохід. Після цього всерйоз BitBoys перестали сприймати як геймери, так і журналісти.

Демонстрація Glaze3D

Кінець 2001 року став кінцем постійних гучних анонсів. Infineon Technologies, партнер BitBoys, закрив фабрику, яка виробляла чіпи з вбудованою пам’яттю, відповідно випускати чіпи ніхто вже й не міг.

Сама компанія не зникла з ринку. Вона перекваліфікувалася. BitBoys стали розробляти чіпи для мобільних телефонів. Так, у 2002 році прибуток компанії склав 150 000 євро. Це напрямок приносило користь компанії, і в 2006 році купила ATI. Це стало доказом того, що, незважаючи на голослівні заяви про прийдешні чіпах, в BitBoys були уми, здатні створити щось перспективне. В кінцевому підсумку складу BitBoys перейшов до Qualcomm.

Повернутися до змісту

Новітня історія

2001 рік ознаменував новий виток розвитку комп’ютерної графіки. NVIDIA випустила свій новий чіп NV20, який став основою GeForce3. Продуктивність не дуже далеко пішла від GeForce2, проте вийшов він в один час з DirectX 8.0, стандартизировавший піксельні і вершинні шейдери 1.0. За фактом, шейдерні блоки були присутні і GeForce2, однак їм потрібна була підтримка від графічних бібліотек в самих іграх, інакше вони просто не працювали. Але ігри, які отримали підтримку DirectX 8.0, показували чудову картинку.

NVIDIA GeForce2

GeForce3 з чіпом NV20

Відповідь, пішов від ATI, виявився дуже потужним. ATI не збиралися продовжувати займати друге місце і спробували обігнати головного конкурента. Випущений компанією R200 володів підтримкою шейдерів версії 1.4, які були у складі DirectX 8.1. Крім іншого, Radeon додав апаратну тесселяцію, яка дала чіпу можливість самостійно робити моделі об’єктів більш складними.

Удар ATI NVIDIA: відеокарта ATI R200

Ну а відповідь NVIDIA здивував усіх. Його просто не було. Однак у компанії міркували дуже хитро і розумно: адже розробники ігор не будуть вкладати гроші для підтримки технологій, що належать тільки ATI. Виходить, що NVIDIA не намагалася наздогнати флагмана від ATI і наступним адаптером у неї став NV25 (GeForce4Ti), не підтримує тесселяцію та версія шейдерів, використовувану товаром ATI. Задум NVIDIA можна сказати виправдався: розробники ігор не дуже хотіли впроваджувати в свої ігри підтримку нових версій шейдерів і TruForm. Незважаючи ні на що, NVIDIA не займала чітко друге місце – компанії ділили лідерство, а NVIDIA готувала потужні відповіді для ATI (нині куплена компанією AMD).

Так і почалася новітня історія відеокарт. З 2001 року історія відеокарт пишеться двома компаніями: ATI і NVIDIA. За декаду з’являлися і зникали нові покоління чіпів обох компаній, а початкові геометричні та текстурні блоки перетворилися в тисячі вільно програмованих ядер, а компанія-лідер в цій гонці постійно змінюється.

Завдяки цій боротьбі, компанії розробляють нові рішення, технології, встановлюючи нові рекорди продуктивності, а також постійно змінюються ціни. Прикро, звичайно, що в цій боротьбі третій зайвий. І не факт, що він взагалі зможе коли-небудь з’явитися.

Повернутися до змісту

Коротко про шейдери

Будь-який геймер, дизайнер, та й просто той, кому цікаві відеокарти знає терміни «шейдер» і «шейдерний процесор». А що саме це таке?

Шейдер (від англійського слова shader) – це процедура, яка дає опис параметрів того чи іншого об’єкта. Шейдер визначає поглинання та дифракцію світла, що потрапляє на поверхню, саму текстуру поверхні, то як вона затінена або прозора (наприклад, шейдер, що відповідає за відображення хвиль на воді). Виконання цієї процедури лежить якраз на шейдерном процесорі, яких у відеокартах новітньої історії величезна кількість. Шейдери бувають декількох видів.

На вершинном шейдере лежить функція опису вершин трикутників і застосовується він для різних перетворень геометрії об’єкта і ще відповідає за освітлення.

Робота вершинних шейдеров

Піксельні шейдери потрібні для того, щоб обробляти пікселі, складові картинку, завдяки їм розробники керують координатами, глибиною і кольором текстур. З їх допомогою створюються об’єкти, які не складаються з полігонів (наприклад, волосся).

Створення хвиль піксельними шейдерами

Робота з примітивними фігурами, які складаються з кількох вершин, а також допомога процесору у створенні нових об’єктів, увеличивании кількості деталей в моделях і створення рухомих частинок лежить на геометричні шейдери. Наприклад, з їх допомогою створюються сніг, дощ та інші погодні явища.

Фізичні шейдери дозволяють працювати з фізичними властивостями об’єктів, що відповідають за розрахунок в режимі реального часу змін геометрії (таке як зминання коробки при натисканні на неї ногою, деформація корпусу автомобіля при аварії тощо).

Фізичні шейдери за роботою

Після того, як з’явилися геометричні шейдери – архітектура графічних чіпів змінилася. Конвеєри, що становлять спеціалізовані блоки замінилися шейдерними процесорами, які самі виконували функції рендеринга в 3D. Ця архітектура дає можливість вільного розпорядження обчислювальними ресурсами процесора відеокарти, відправляючи більшу кількість шейдерних процесорів на етапи максимального навантаження під час рендеринга зображення. Крім цього, шейдерні процесори використовуються не тільки для 3D-графіки, але і для розрахунків, необхідних науковій сфері (технологія NVIDIA CUDA).